Indice dei capitoli

- Introduzione: “credi a ciò che vedi” non è più una frase valida

- Falsi influencer, musica artificiale e video AI al telegiornale

- Cosa sono i deepfake e perché sono così pericolosi

- Le piattaforme stanno reagendo? Etichette, filtri e limiti

- Il ruolo dell’educazione digitale e dei media

- Cosa possiamo fare noi

- Conclusione – Difendere la verità nell’era dell’AI

Introduzione: “credi a ciò che vedi” non è più una frase valida

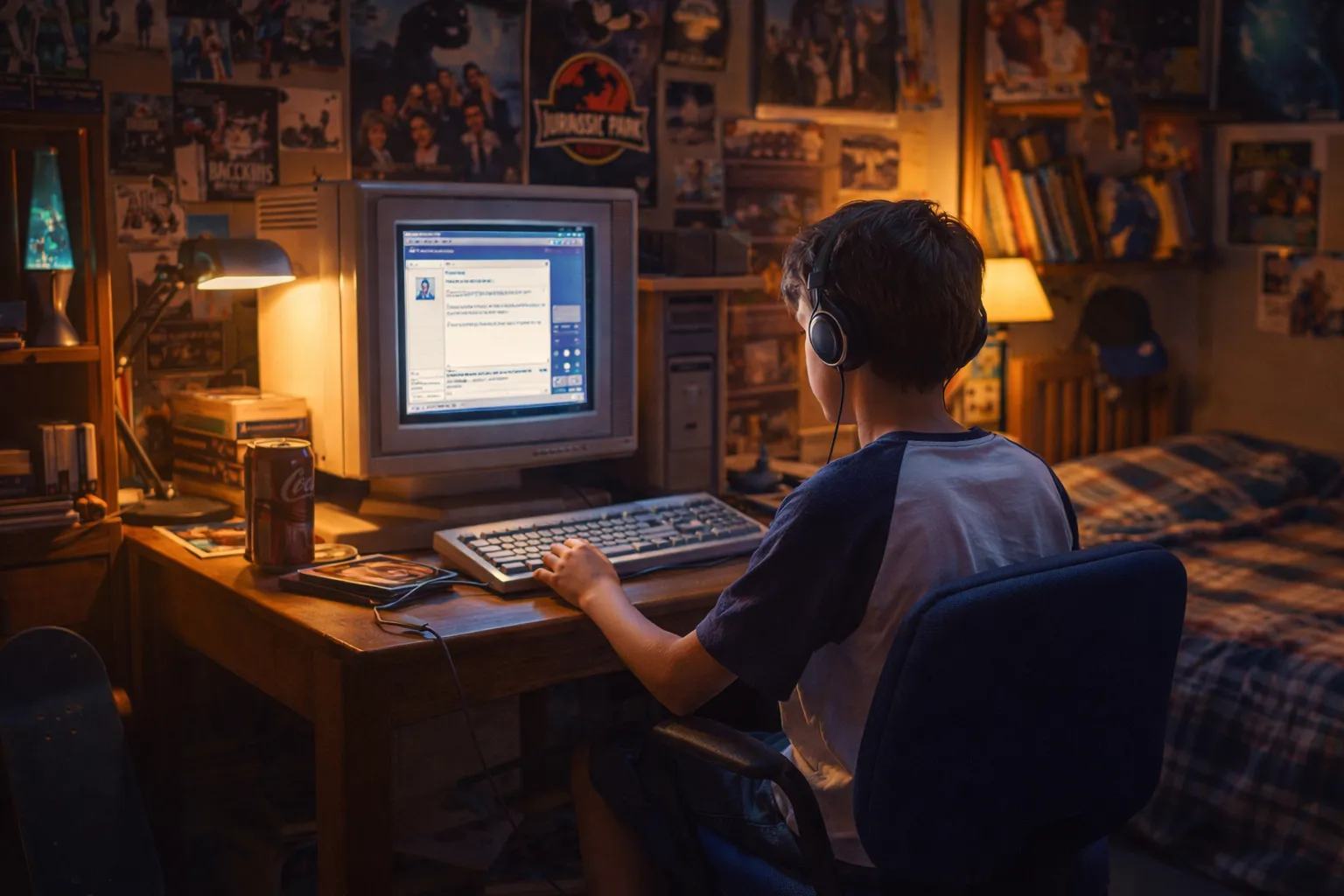

Per decenni abbiamo creduto che una fotografia o un video fossero prove affidabili della realtà. “Se lo vedo, ci credo” era una regola quasi automatica. Oggi non è più così. Con l’avvento dell’intelligenza artificiale generativa, creare immagini, voci e video indistinguibili dal reale è diventato semplice, veloce e alla portata di chiunque.

La difficoltà nel distinguere contenuti autentici da quelli artificiali sta creando una vera e propria crisi della fiducia visiva. Non si tratta solo di immagini artistiche o esperimenti creativi: sempre più spesso contenuti generati dall’AI vengono scambiati per reali, influenzando opinioni, emozioni e decisioni.

Falsi influencer, musica artificiale e video AI al telegiornale

Sui social network esistono profili con milioni di follower che in realtà non appartengono a persone vere. Sono volti generati dall’intelligenza artificiale, costruiti con tratti perfetti, vite curate nei minimi dettagli e storie completamente inventate. Alcuni collaborano persino con brand reali, monetizzando come veri influencer.

Nel mondo della musica stanno emergendo profili di artisti che pubblicano brani creati interamente dall’AI: voce, testi, produzione. A volte gli ascoltatori non sanno nemmeno che dietro quel “cantante” non esiste una persona reale. Le piattaforme di streaming si trovano così a ospitare artisti virtuali che competono con musicisti in carne e ossa.

Il caso più preoccupante riguarda i video: immagini generate artificialmente sono già circolate come se fossero riprese autentiche di eventi, guerre o disastri. In alcuni casi, contenuti AI sono stati trasmessi anche in contesti informativi prima di essere verificati a fondo. Questo dimostra quanto sia diventato difficile distinguere realtà e finzione, persino per i professionisti dell’informazione.

Cosa sono i deepfake e perché sono così pericolosi

I deepfake sono contenuti audio o video manipolati tramite intelligenza artificiale per sostituire il volto o la voce di una persona con quella di un’altra in modo estremamente realistico. Il termine deriva dall’unione di “deep learning” (una tecnologia di apprendimento automatico) e “fake” (falso).

Con questa tecnologia è possibile far dire o fare a qualcuno qualcosa che non ha mai detto o fatto. I deepfake possono essere usati per scopi innocui o artistici, ma rappresentano un grande rischio quando vengono impiegati per diffondere disinformazione, truffe, manipolazione politica o danneggiare la reputazione di una persona.

La loro pericolosità sta proprio nella credibilità: più la tecnologia migliora, più diventa difficile smascherare la falsificazione a occhio nudo.

Le piattaforme stanno reagendo? Etichette, filtri e limiti

Le grandi piattaforme digitali stanno cercando di correre ai ripari. Alcune hanno introdotto etichette che segnalano quando un contenuto è stato generato o modificato dall’intelligenza artificiale. In certi casi, i sistemi automatici analizzano immagini e video per individuare manipolazioni sospette.Altre aziende stanno sviluppando strumenti di “watermarking” digitale: una sorta di firma invisibile inserita nei contenuti creati con AI, per renderli riconoscibili anche dopo la condivisione.Nel settore dell’informazione, molte redazioni stanno rafforzando i processi di verifica, introducendo team specializzati nel fact-checking digitale. Tuttavia, il problema resta complesso: non tutti i contenuti AI sono dichiarati, non tutti i sistemi di rilevamento sono infallibili e la tecnologia evolve più rapidamente delle regole.

Il ruolo dell’educazione digitale e dei media

Oltre alle soluzioni tecniche, sta emergendo un’esigenza fondamentale: l’educazione digitale. Scuole, università e media devono insegnare non solo come funziona l’intelligenza artificiale, ma anche quali rischi comporta. Comprendere i meccanismi di base dell’AI aiuta a sviluppare uno sguardo più consapevole sui contenuti che consumiamo ogni giorno.

Imparare a dubitare in modo sano, verificare le fonti e analizzare il contesto è ormai essenziale. Oggi esistono ancora alcuni indizi utili per distinguere un contenuto reale da uno generato artificialmente: mani con dettagli strani, ombre incoerenti, movimenti del volto innaturali, labiale non sincronizzato o metadati sospetti. Tuttavia, questi segnali non sono definitivi. I modelli di AI migliorano rapidamente e molti errori tipici sono già stati corretti.

In un futuro molto vicino potrebbe diventare quasi impossibile distinguere a occhio nudo il vero dal falso. Per questo non basta conoscere i “trucchi”: serve sviluppare pensiero critico, capacità di verifica e consapevolezza dei meccanismi della disinformazione.

Cosa possiamo fare noi

Anche come singoli utenti possiamo fare molto per combattere la disinformazione online. Prima di condividere contenuti che ci colpiscono emotivamente, è importante fermarsi e verificarne l’attendibilità: non tutto ciò che suscita rabbia, paura o meraviglia è necessariamente vero. Controllare sempre la fonte originale di immagini, video o notizie può aiutarci a capire se il contenuto è reale o manipolato. Diffidare di titoli sensazionalistici, articoli troppo perfetti o post che confermano solo le nostre convinzioni è un altro passo fondamentale.

Oggi esistono strumenti gratuiti di verifica online che permettono di controllare foto, video e articoli in pochi minuti, e imparare a usarli fa davvero la differenza. Infine, quando ci imbattiamo in contenuti sospetti o palesemente falsi, segnalarli alle piattaforme aiuta a limitare la loro diffusione. In questo modo, anche noi diventiamo parte della soluzione, contribuendo a un’informazione più corretta e responsabile.

Ogni condivisione contribuisce a rafforzare o a indebolire la qualità dell’informazione online. La responsabilità non è solo delle aziende tecnologiche, ma anche nostra.

Conclusione – Difendere la verità nell’era dell’AI

L’intelligenza artificiale rappresenta una straordinaria opportunità creativa e tecnologica, ma porta con sé una sfida enorme: preservare la fiducia nella realtà. Se non possiamo più credere automaticamente a ciò che vediamo, dobbiamo imparare a sviluppare nuovi strumenti culturali e critici.

La vera sfida del futuro non sarà solo distinguere tra reale e artificiale, ma costruire un ecosistema digitale in cui trasparenza, responsabilità e consapevolezza diventino la norma. In un mondo dove tutto può essere creato, la verità diventa un valore da proteggere attivamente.

Ilaria Brozzi